SAINT-MARTIN D’HÈRES, França: Uma equipe de investigação francesa desenvolveu um sistema que pode mostrar os movimentos da língua em tempo real. Este sistema de biofeedback visual, que se espera venha a conduzir a facilitar a compreensão do movimento da língua e, portanto, melhor ajudar na correção da pronúncia, poderiam ser usados para terapia da fala e para a aprendizagem de línguas estrangeiras.

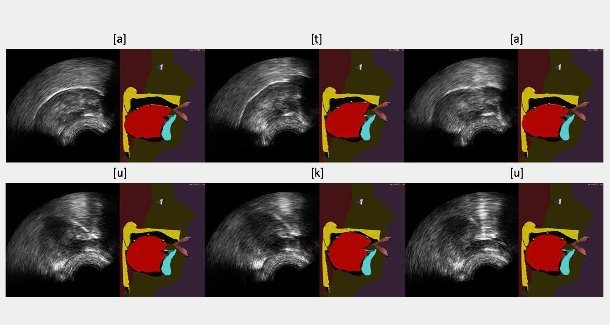

Capturado usando uma sonda de ultrassom colocada sob a mandíbula, os movimentos da língua são processados através de uma máquina de aprendizado de algoritmo que controla uma cabeça falante articulatória. Assim como a face e lábios, este avatar mostra a língua, palato e dentes, que são geralmente escondidos dentro o trato vocal.

Para uma pessoa com um transtorno da articulação, a terapia da fala em parte utiliza exercícios de repetição. O médico analisa qualitativamente as pronúncias do paciente e explica oralmente, utilizando desenhos, como colocar articuladores, especialmente a língua – coisa que os pacientes geralmente ignoram. A eficácia da terapia depende de quão bem o paciente pode implementar o que foi dito a ele. É nesta fase que o sistema de biofeedback visual pode ajudar. Eles permitem que os pacientes vejam seus movimentos articulatórios, em tempo real, e, em especial, como as suas línguas se movem, de modo que eles estão conscientes desses movimentos e podem corrigir problemas de pronúncia mais rápido.

Durante vários anos, pesquisadores têm usado ultrassom para projetar sistemas de biofeedback. A imagem da língua é obtida através da colocação de uma sonda sob a mandíbula semelhante a usado convencionalmente para olhar um coração ou feto. Esta imagem é por vezes considerada difícil de usar para um paciente porque ela não é de muito boa qualidade e não fornece qualquer informação sobre a localização do palato e dentes. Em um novo projeto, a presente equipe de pesquisadores propôs a melhoria do visual, automaticamente, animando uma cabeça falante articulatória, em tempo real com base em imagens de ultrassom. Este clone virtual de um falante real, em desenvolvimento há muitos anos no GIPSA-Lab (uma unidade de pesquisa do National Center for Scientific Research, o Grenoble Institute of Technology e a Université Grenoble Alpes), produz uma contextualizada – portanto mais natural – visualização dos movimentos articulatórios.

A força deste novo sistema, desenvolvido por pesquisadores do GIPSA-Lab e no Inria Grenoble Rhône-Alpes Research Centre, encontra-se no algoritmo de aprendizado da máquina. Este algoritmo pode – dentro dos limites – processar movimentos articulatórios, que os usuários não podem alcançar quando eles começam a utilizar o sistema. Esta propriedade é indispensável para as aplicações terapêuticas. O algoritmo explora um modelo probabilístico baseado em um grande banco de dados articulatórios adquiridos de um orador especialista capaz de pronunciar todos os sons em um ou mais idiomas. Este modelo é automaticamente adaptado à morfologia de cada novo usuário ao longo de uma curta fase de calibração do sistema, durante o qual o paciente deve pronunciar algumas frases.

O sistema, validado em um laboratório para falantes saudáveis, agora está sendo testado em uma versão simplificada em um ensaio clínico para pacientes que tiveram a cirurgia da língua. Os pesquisadores também estão desenvolvendo uma outra versão do sistema, onde a cabeça falante articulatória não é automaticamente animada por ultrassons, mas diretamente pela voz do utilizador.

O estudo, intitulado “Animação automática de um modelo de língua articulatória por imagens de ultrassom do trato vocal”, foi publicado na edição de outubro do Speech Communication Journal.

Deixe seu Comentário.

Comentários no Facebook